在现代企业中,数据分析已成为推动决策的核心力量。然而,许多人对行业数据分析的技术架构背后运作机制知之甚少。这篇文章将揭示这些技术架构的复杂性,以及它们如何帮助企业获取竞争优势。在这过程中,我们会发现,理解数据分析的背后机制不仅是技术人员的工作,也是每个希望在数据驱动时代中立于不败之地的企业决策者的必修课。

🚀 一、行业数据分析技术架构的基本组成

数据分析技术架构并不是单一的系统,而是由多个模块组成的综合体,这些模块各司其职,共同支撑整个数据分析流程。理解这些模块的角色和其协作方式是解开数据分析运作机制的第一步。

1. 数据收集与存储

数据分析的第一步是数据的收集与存储,这一阶段的质量直接影响后续分析的准确性。现代企业通常从多种来源收集数据,包括内部的ERP系统、CRM系统,以及外部的社交媒体、网络日志等。这些数据通常以不同的形式存在,需要通过ETL(Extract, Transform, Load)工具来进行预处理。

在数据存储方面,企业往往面临选择:使用传统的关系型数据库还是现代的NoSQL数据库。关系型数据库如MySQL、PostgreSQL,以其稳定性和成熟的技术支持著称。而NoSQL数据库如MongoDB、Cassandra,则因其高性能、高扩展性和灵活性在处理大规模非结构化数据时表现优异。

表:数据收集与存储的工具对比

| 特性 | 关系型数据库 | NoSQL数据库 |

|---|---|---|

| 数据结构 | 表格化 | 非结构化 |

| 扩展性 | 中等 | 高 |

| 适用场景 | 事务处理 | 大数据分析 |

| 成本 | 较低 | 较高 |

- ETL工具的选择是数据收集的关键,需根据数据复杂性与分析目标选择合适的工具。

- 关系型与NoSQL数据库各有优劣,企业应根据数据类型和规模进行选择。

2. 数据处理与清洗

数据处理与清洗是确保数据分析结果准确性的关键步骤。在数据处理阶段,企业需要使用算法来过滤、转换和聚合数据。这些算法可以是简单的统计计算,也可能涉及复杂的机器学习模型。

数据清洗则是去除无效或错误数据的过程。通常包括重复数据的去除、异常值的处理以及数据补全等步骤。数据清洗后的结果将直接影响分析的精准度,因此这一阶段通常需要大量人力和技术投入。

对于数据清洗,企业常常依赖于自动化工具,如Trifacta或OpenRefine,以提高效率和准确性。此外,拥有一套完善的数据质量监控机制也是必不可少的,以确保数据持续保持高质量。

- 算法选择影响数据处理的效率和结果,应根据具体分析需求调整。

- 数据清洗工具的使用可以显著提高质量控制效率。

📈 二、数据分析与可视化

在数据分析技术架构中,数据分析与可视化是将数据转化为洞察的核心步骤。通过适当的分析工具和可视化技术,企业能够快速识别趋势、异常和机会。

1. 数据分析工具

数据分析工具的选用直接决定了分析效率和结果的深度。现代企业普遍采用BI(Business Intelligence)工具进行数据分析。这些工具利用复杂的算法和模型,帮助企业挖掘数据中的隐藏价值。

表:常见数据分析工具对比

| 工具 | 主要功能 | 优势 | 劣势 |

|---|---|---|---|

| Tableau | 可视化分析 | 界面友好 | 学习成本高 |

| Power BI | 数据整合与分析 | 与微软产品集成 | 数据处理能力有限 |

| FineBI | 自助分析平台 | 市场占有率第一 | 需要学习使用方法 |

- BI工具的选择应结合企业的数据规模和分析目标。

- FineBI的使用因其市场领先地位和功能全面性,是企业值得考虑的选择。

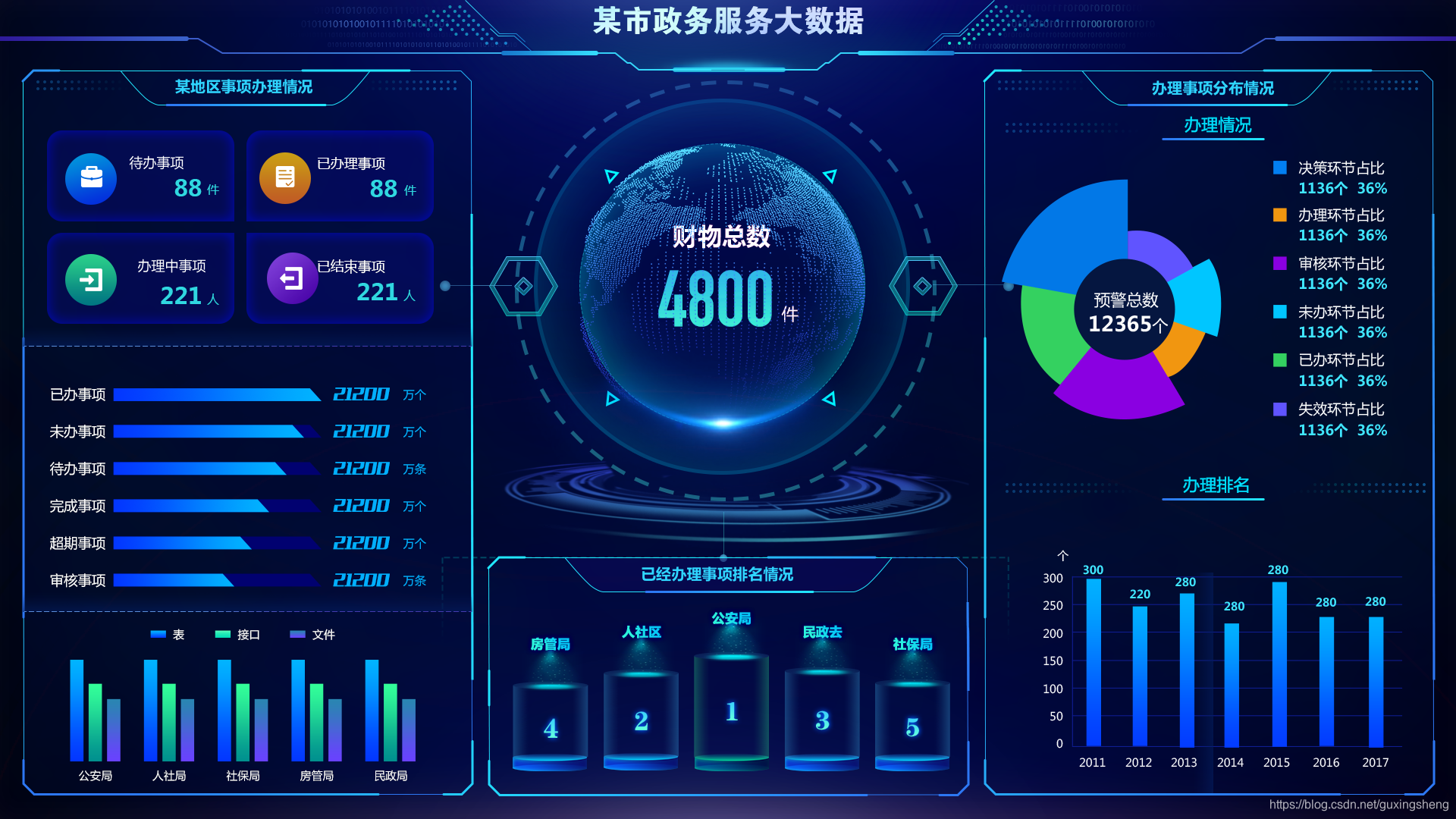

2. 数据可视化技术

数据可视化是将复杂数据转化为易于理解的图形或图表的技术。通过数据可视化,企业能够更直观地理解数据,快速做出决策。

常用的可视化技术包括饼图、柱状图、折线图、热力图等。不同的可视化方法适用不同类型的数据和分析目标。例如,饼图适合展示比例关系,而折线图则适合展示趋势变化。

此外,交互式可视化技术的兴起,如通过Dashboards实现实时数据监控与分析,进一步提高了企业对数据的敏捷反应能力。

- 可视化方法选择应考虑数据类型和展示目的。

- 交互式可视化为实时监控和分析提供了更高的灵活性。

🛠 三、数据共享与管理

数据共享与管理是数据分析技术架构中确保数据安全和流通的关键环节。在这一阶段,企业需要建立有效的机制来管理数据访问权限、确保数据安全、以及促进高效的数据共享。

1. 数据共享机制

数据共享机制的核心是确保数据在企业内部的流通畅通无阻,同时不损害数据的安全性。为了做到这一点,企业通常依赖于数据共享平台和API技术。

数据共享平台可以是一个中心化的数据仓库,所有部门的数据都在这里汇集和共享。而API则提供了一种标准化的数据交互方式,使不同系统之间的数据共享更加高效。

表:数据共享机制对比

| 机制 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|

| 数据仓库 | 集中管理 | 部署复杂 | 大型企业 |

| API | 高效交互 | 安全性风险 | 跨系统集成 |

- 数据仓库适合大型企业的集中化数据管理。

- API技术提供了灵活的跨系统数据交互方式。

2. 数据管理与安全

数据管理与安全是确保数据在整个分析过程中保持完整性和隐私性的重要步骤。企业需要建立强大的数据治理框架,以确保数据的准确性、完整性和安全性。

数据安全技术包括加密、访问控制和审计跟踪等。这些技术能够帮助企业保护敏感数据,防止数据泄露或未经授权的访问。

此外,数据治理框架的建立需要企业在政策、流程和技术上进行全面布局,以确保数据在整个生命周期内的质量和安全。

- 数据安全技术是保护敏感信息的关键,需结合企业需求进行部署。

- 数据治理框架需全面布局,以确保数据质量和安全。

📚 结论与思考

通过全面深入地探讨行业数据分析的技术架构,我们发现它不仅是技术层面的挑战,更涉及到企业文化和管理机制的深刻变革。理解这些架构背后的运作机制能够帮助企业更好地利用数据,做出明智的决策,进而在竞争中脱颖而出。随着技术的不断发展,企业必须保持灵活和开放,以适应数据分析领域的快速变化。

参考文献:

- 陈越,《大数据时代的数据分析与决策》,清华大学出版社,2020。

- 李明,《商业智能与数据仓库》,机械工业出版社,2018。

- 王强,《企业数据治理实战》,电子工业出版社,2019。

通过这篇文章,您不仅对行业数据分析技术架构有了更深的理解,也获得了在数据驱动时代中保持领先的策略和方法。希望这能为您的企业决策提供有力支持。

本文相关FAQs

📊 如何理解行业数据分析的技术架构?

老板要求我负责公司数据分析项目,可是我对技术架构一知半解。行业数据分析的技术架构到底包括哪些部分?有没有大佬能简单解释一下?我希望能快速了解它们的基本组成和作用。

行业数据分析的技术架构是一个复杂的系统,通常包括数据源、数据集成、数据存储、数据处理和分析、以及数据可视化和共享这几个关键环节。这一套架构的设计和实施可以根据企业的具体需求和现有的技术条件进行定制。首先,数据源是所有分析的起点,数据可以来自内部数据库、外部API、甚至是传感器数据等多种渠道。接下来是数据集成,这一步骤的目的是将多种来源的数据进行汇集和转换,以保证数据的一致性和准确性。数据集成工具如ETL(Extract, Transform, Load)在此阶段发挥重要作用。

数据存储则是将整理好的数据保存在一个便于快速访问和处理的位置,比如数据仓库或数据湖。选择合适的存储技术(如SQL数据库、NoSQL数据库或云存储)需要考虑数据规模、访问频率和成本等因素。在数据处理和分析阶段,数据科学家和分析师会使用各种工具和算法来挖掘数据背后的趋势和模式,机器学习和人工智能技术在这一环节中日益受到重视。最终,数据的洞察结果通过数据可视化工具展现出来,以便于决策者快速理解和应用。工具如FineBI等BI软件在此阶段大显身手。更多关于FineBI的功能及应用可以参考这个链接: FineBI在线试用 。

通过以上几个步骤,一个完整的数据分析架构能够帮助企业从海量数据中提取有价值的信息,并在业务决策中发挥作用。尽管每个环节看似独立,但它们之间紧密相连,任何一个环节出现问题都会影响最终的分析效果。

🛠️ 如何选择合适的数据分析工具?

公司准备上马一套数据分析系统,但市面上的工具多得眼花缭乱。选择工具时应该考虑哪些因素?有没有推荐的实用工具?希望能听到一些真实的使用经验。

选择合适的数据分析工具时,首先要明确企业的具体需求和现有的技术条件。不同的工具在功能、易用性、扩展性等方面有很大差异,因此要根据实际情况进行选择。关键考虑因素包括数据处理能力、可视化功能、用户友好性、以及成本。

在数据处理能力方面,工具需要能高效处理企业规模的数据量,并支持多种数据源的集成。比如,FineBI提供了强大的数据处理和整合功能,支持大规模数据的快速分析。在可视化功能方面,工具应提供多样化的图表和仪表盘选项,帮助用户直观地理解分析结果。FineBI的可视化功能非常灵活,可根据用户的需求进行自定义配置。

用户友好性是选择工具时的另一个重要考量。企业内部可能有不同技术背景的用户,因此工具的操作界面和使用指南应该尽可能地简单易懂。FineBI在这方面表现突出,通过自助式的分析平台降低了使用门槛。在成本方面,除了工具本身的购买费用外,还需考虑后续的维护、升级和人员培训等隐性成本。

以下是一份选择数据分析工具时的简单对比表:

| 考虑因素 | FineBI | 其他工具A | 其他工具B |

|---|---|---|---|

| 数据处理能力 | 高效 | 中等 | 高效 |

| 可视化功能 | 强大 | 普通 | 强大 |

| 用户友好性 | 友好 | 一般 | 复杂 |

| 成本 | 中等 | 低 | 高 |

通过对比,可以看到FineBI在多个方面都具有竞争优势。选择合适的工具将大大提高数据分析项目的成功率和效率。

🤔 数据分析项目遇到瓶颈怎么办?

公司数据分析项目进行到一半,突然发现数据质量不过关,分析结果也不准确。有没有人遇到过类似问题?这种情况下应该如何调整策略?

数据分析项目中遇到瓶颈是常见的挑战,尤其是数据质量问题会直接影响分析结果的准确性和可靠性。首先需要从源头上解决数据质量问题,这通常包括数据的清洗、验证和一致性检查。要确保数据在进入分析阶段之前是准确和完整的,可以使用一些专业的数据清洗工具或者编写脚本来自动化这个过程。

如果问题在于数据的缺失或者不一致,可以通过数据补全和数据标准化来改善。数据补全可以通过历史数据的模式识别或者外部数据源进行填充,而数据标准化则确保不同来源的数据在单位、格式和范围上保持一致。

在技术方面,引入更为先进的数据治理框架可能是一个解决方案,它可以帮助管理和监控整个数据生命周期,确保数据在不同环节的质量和安全。考虑实施数据治理工具,这不仅提高数据质量,还能优化数据管理流程。

同时,团队协作和沟通也是解决瓶颈的重要因素。确保团队成员之间的信息透明,定期召开会议讨论进展和问题,集思广益找到解决方案。在这方面,FineBI的协同功能可以帮助团队成员共享分析结果和洞察,及时反馈和调整策略。

最后,项目的灵活性也很重要。遇到问题时,不要拘泥于原计划,适时调整策略和方法。例如,可以重新评估和调整数据分析模型,或者根据新的需求调整分析框架。

数据分析项目是一个动态过程,不可避免地会遇到各种挑战。通过适当的工具、合理的策略和有效的团队协作,可以克服这些困难,确保项目的成功。